Китайцы разработали процессор для машинного зрения, который в 3 тыс раз быстрее и в 4 млн раз эффективнее современного ГПУ

Учёные из китайского университета Цинхуа разработали полностью аналоговый фотоэлектронный чип ACCEL, который обещает совершить революцию в задачах высокоскоростного машинного зрения. Чип, сочетающий электронные и оптические технологии, способен продемонстрировать беспрецедентную энергоэффективность и высочайшую скорость вычислений для задач машинного зрения. В этой сфере новый чип радикально превосходит современные графические процессоры.

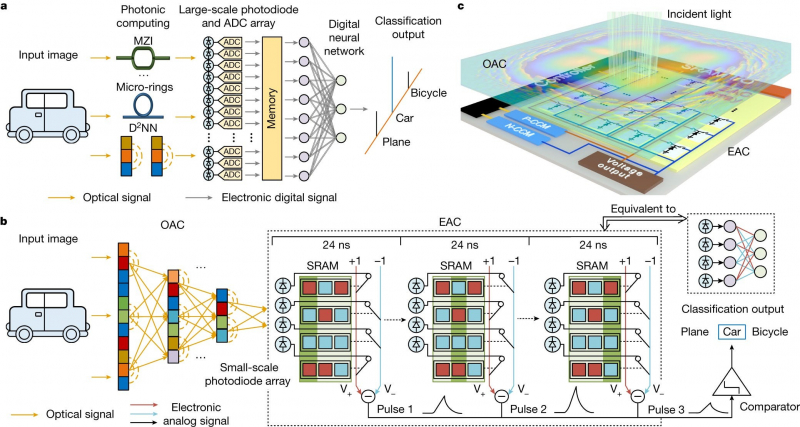

Чип ACCEL реализует преимущества развивающейся области фотонных вычислений, которые используют свет для обработки информации. Интегрируя дифракционные оптические аналоговые вычисления (OAC) и электронные аналоговые вычисления (EAC) в одном чипе, ACCEL достигает замечательной энергоэффективности и скорости вычислений.

Метод OAC использует управление световыми волнами посредством дифракции для кодирования и обработки информации. При помощи интерференционных паттернов, создаваемых светом, вычисления производятся аналоговым способом, обрабатывая данные непрерывно, а не дискретными цифровыми шагами. Метод EAC использует электронные компоненты для манипулирования непрерывными физическими величинами. Вместо работы с цифровыми сигналами в виде нулей и единиц, EAC использует постоянно меняющиеся аналоговые сигналы.

ACCEL при обработке изображений не требует АЦП для преобразования изображения, напрямую используя для вычислений фототоки, индуцированные светом, что приводит к значительному сокращению задержек. ACCEL достигает системной энергоэффективности 74,8 пета-операций в секунду на ватт, что более чем на три порядка выше, чем у современных графических процессоров. Скорость вычислений достигает 4,6 пета-операций в секунду, при этом более 99 % вычислений выполняются оптически.

Благодаря интеграции оптоэлектронных вычислений и адаптивного обучения ACCEL достигает конкурентоспособной точности классификации объектов в различных задачах. Новый чип продемонстрировал точность 85,5 %, 82,0 % и 92,6 % для задач Fashion-MNIST, 3-классовой классификации ImageNet и задач распознавания покадрового видео соответственно.

Источник: 3DNews

Дата публикации: 31.10.2023

Первоисточник: Nature